In der "Deus Ex Machina? – KI-Tools im Test"-Reihe stellen wir euch verschiedene Tools vor, die mithilfe von Künstlicher Intelligenz Schreib‑, Design- und Rechercheprozesse vereinfachen sollen. Mehr zur "Deus Ex Machina?"-Reihe gibt es hier.

Im Überblick

Vergangenen März veröffentlichte das New Yorker Unternehmen Runway die zweite Generation seines Online-Tools Runway Research. Ähnlich wie bei den Text-zu-Bild-Tools Midjourney und DALL‑E erzeugt Runway Research Generation 2 aus Texteingaben und Bildvorlagen neue Bilder und Videos.

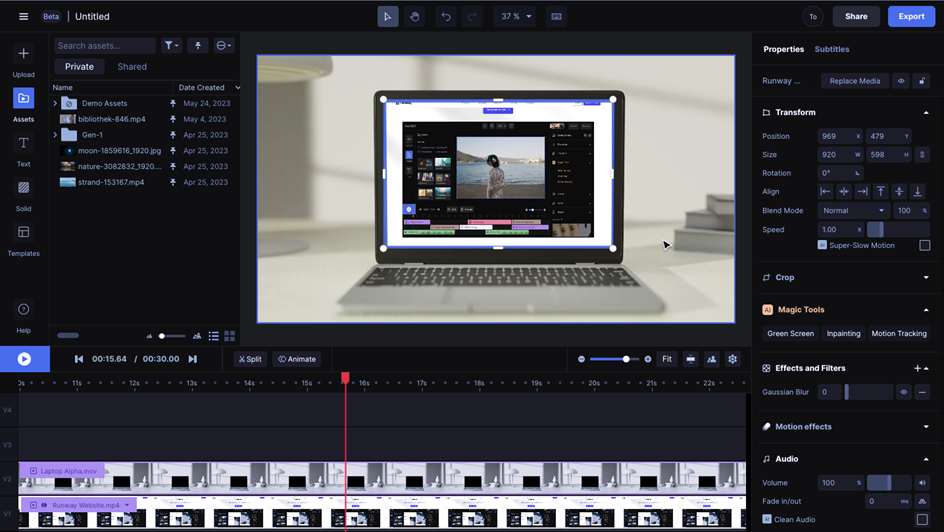

Neben dem browserbasierten Video-Editor, der zumindest im Schnittbereich stark an Adobes Premier Cut oder das kostenlose Schnittprogramm DaVinci erinnert, gibt es auch nutzbare Vorlagen für audiovisuelle Clips und Präsentationen. Diese können mit Stockmaterial oder eigenen Aufnahmen personalisiert werden. Für die Nachbearbeitung von Videos in ihrer Helligkeit und Farbe bietet der Editor keine Funktionen, er eignet sich eher für das Anordnen und Schneiden fertiger Clips sowie das Zusammenbringen mit Text und Audio.

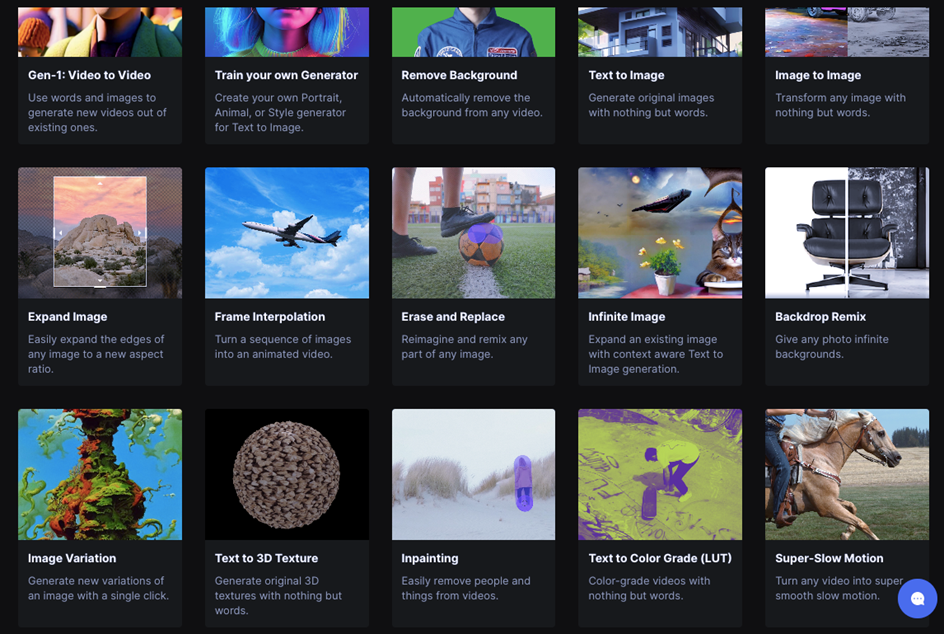

Funktionen, um die Clips weiter zu bearbeiten, bieten die verschiedenen AI Magic Tools, die sich in neuen Tabs öffnen lassen. Anhand dieser Funktionen können eigene Videos automatisch mit Untertiteln versehen, im Ton optimiert oder in der Farbe korrigiert werden. Außerdem lassen sich Objekte und Personen entfernen oder vom Hintergrund trennen.

Alle bis hier genannte Funktionen sind nach Angabe einer E‑Mail-Adresse nutzbar. Im kostenlosen Abonnement ist die Anzahl an Gesamtsekunden für Bearbeitungen am Bewegtbild stark begrenzt und es gibt Einschränkungen in der Qualität beim Export sowie eine limitierte Anzahl an Generierungsversuchen. Aufstocken lässt sich das Tool durch Bezahlabonnements, die entweder 12 $ oder 28 $ im Monat kosten und qualitativ hochwertigere Ergebnisse ohne zeitliche Begrenzung der Exponate ermöglichen.

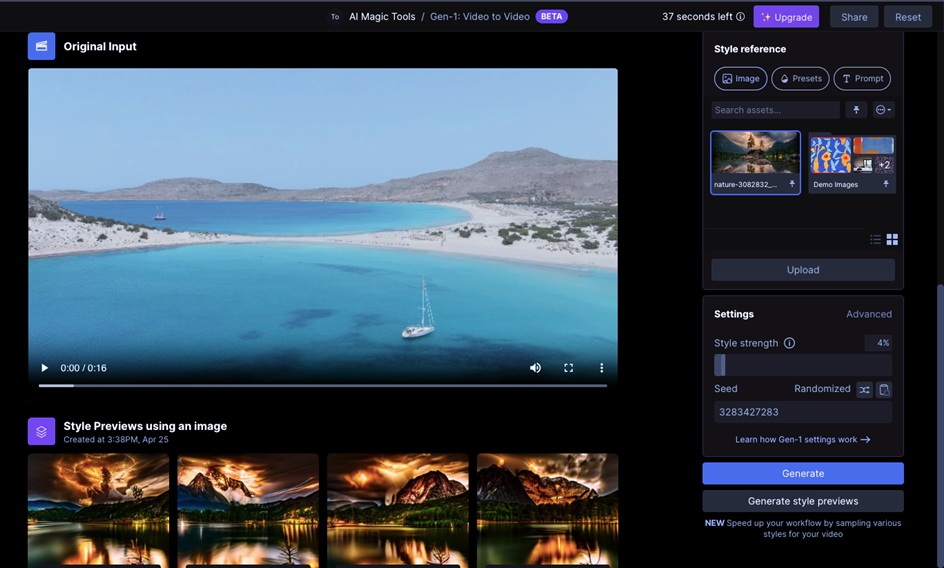

Ebenfalls kostenlos nutzbar und in Tradition zur ersten Generation des Tools steht die Funktion, mit einer trainierten Intelligenz Videos zu generieren. Mit einem Bild oder Text als Prompt lassen sich neue Videos erstellen und anhand bestehender Videos können ganz neue Szenen kreiert und visual effects eingebaut werden. Wer den diesjährigen siebenfachen Oscargewinner Everything Everywhere All at Once gesehen hat, erinnert sich vielleicht an die Szene mit den beiden Steinen, deren Bewegungen unter anderem mit diesem Tool animiert wurden. In einem Interview, das Runway auf seiner Website veröffentlichte, berichtet Evan Hadleck, einer der visual effect artists des Films, wie ihn das Tool bei der Produktion von Musikvideos und Werbespots unterstützt.

Die KI hinter der Anwendung

Neben diesem Interview veröffentlichte Runway nicht nur weitere Berichte über Filmschaffende, die ihr Tool nutzen, sondern verweist dort auch auf verschiedene Paper mit Informationen zur Programmierung und Entwicklung des Tools. Diese sind über die Website der Cornell University frei zugänglich. Jedoch geben die Dokumente zu Runway Generation 1 für Interessierte ohne Programmierkenntnisse nur wenig Aufschluss zur Funktionsweise.

Das Paper zur Generation 2 soll noch dieses Jahr veröffentlicht werden und die Entwicklung sowie das Training des Tools kommunizieren. In den sechs Monaten seit Veröffentlichung wurden jedoch noch keine derartigen Informationen publiziert und es finden sich keine Informationen zur Anwendung und ihrem Training. Auch ob die von den Nutzer:innen hochgeladenen Videos und Bilder genutzt werden, um Gen‑2 weiterzutrainieren und unter Umständen in Teilen den Arbeiten anderer Nutzer:innen auftauchen, ist nicht bisher nicht bekannt (Stand August 2023).

Das rhetorische Potenzial des Tools

Erklärfreundlicher hingegen sind die Tutorials, die zu den einzelnen Funktionen auf YouTube zu finden sind. Auf einem eigenen Kanal wird in mehreren Videos die Anwendung der Tools gezeigt und die "next-generation content creation with artificial intelligence", also die Erstellung von Inhalten der nächsten Generation durch künstliche Intelligenz präsentiert. Kombiniert wird das Motto dabei häufig mit dem Versprechen, kreatives Arbeiten zu unterstützen und Kosten für die Erstellung visueller Medien zu senken, da mit dem Tool ganze Filme erstellt werden können, ohne dass die meist kostspielige Aufnahme von Filmmaterial nötig ist.

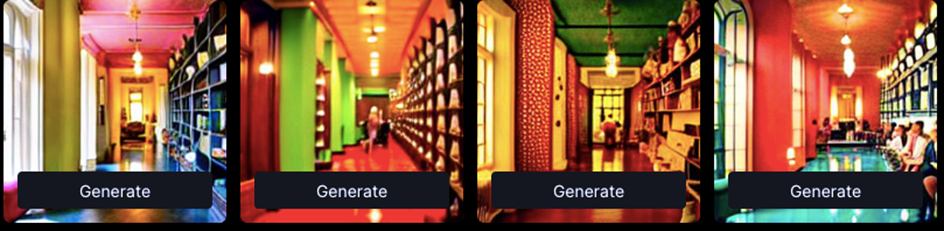

Dies erfordert jedoch einiges an Übung und Geduld, da authentisch wirkende Ergebnisse nicht immer garantiert sind und von Ausgangsmaterial und Prompt abhängen. Darstellungen von nicht vorhandenen Personen in einem Video funktionieren weniger überzeugend, wie das Beispielvideo des Bibliotheksflurs zeigt. Mit der Ergänzung der Person verliert das Video an Realität (siehe Video 2). Für abstrakte Spielereien hingegen lohnt sich das Ausprobieren verschiedener Befehle und Einstellungen (siehe Video 3).

Änderungen an einem Video durch ein Ausgangsbild funktionieren meist recht zuverlässig. Das Ändern eines blauen Himmels hin zu einem eindrücklichen Farbspektakel, wie im folgenden Beispiel, funktioniert in wenigen Klicks.

Schließlich kann das Tool durch deskriptive Texteingabe auch bekannte "Looks" imitieren, die bestimmte Assoziationen beim Zielpublikum auslösen (sollen). So ergibt die Eingabe "Wes Anderson Style" farbintensive Vorschläge, die durchaus an die detailverliebte und architekturbetonende Handschrift des Regisseurs erinnern.

Einsatz in der Wissenschaftskommunikation

Der Aufbau des Video-Editors ist einfach und intuitiv bedienbar. Er erlaubt grundlegende Bearbeitungen in Schnitt, Text und Audio. Die Schnittvorlagen bieten visuell ansprechende Designs, die sich einfach mit eigenen Texten und Videos füllen lassen. Dies kann vor allem für Schnittunerfahrene hilfreich sein, da diese leicht anzuwenden sind und zuverlässige Ergebnisse liefern. Hier liegt zudem das Potenzial des Tools, dass es auch Unerfahrene bei der Produktion audiovisueller Inhalte unterstützen kann. Und selbst wenn mit Gen‑2 vor allem Filmschaffende angesprochen werden sollen, kann es in der Wissenschaftskommunikation ebenfalls für die Visualisierung von komplexen Inhalten eingesetzt werden, zum Beispiel für das Erstellen von ansehnlichen Präsentationen oder dem Schneiden von kurzen Clips.

Schwierig wird es allerdings bei dem Versuch, angewendete Vorlagen weiter anzupassen oder einzelne Bearbeitungsschritte der KI zu verändern. Das gilt auch für weitere Funktionen, in denen die KI nach nur einem Klick ganze Bearbeitungsschritte übernimmt. Ob bei der Entfernung von Störgeräuschen im Ton oder der Farbkorrektur von Videos: Es gibt kein Protokoll, das die durch die KI getätigten Veränderungen anzeigt und somit auch keine Möglichkeit, die Bearbeitungsschritte des Programms genau nachzuvollziehen. Generierte Veränderungen lassen sich zudem nicht abschwächen, verstärken oder nur in Teilen anwenden. Es ist zwar möglich, die Bearbeitung zurückzusetzen und mit veränderten Parametern erneut zu generieren, allerdings ist dies aufwendig und kostet jedes Mal eine Generierung, die im Free-Account ohnehin begrenzt sind.

Wie viele Generierungen bis zum erwünschten Bild nötig sein können, zeigt sich im Selbstversuch mit dem blauen Schmetterling, der mit der Image-to-Image-Funktion bearbeitet wurde. Dabei sollte durch die Kombination von Bild und Prompt ein neues Bild nach Vorgabe entstehen.

Der Versuch, den Schmetterling per Prompt auf ein Pferd zu setzen, war nicht erfolgreich. Anstelle eines zweiten Tieres hat die KI eine Pferdeweide und eine Stallung in den Bildhintergrund generiert. Die Recolorierung des Schmetterlings funktionierte dafür gut – auch wenn diese im Prompt nicht gefragt war.

Die "Infinite Image"-Funktion, bei der Bilder um einzelne Objekte durch textliche Beschreibung ergänzt werden, liefert oft überzeugende Ergebnisse. Zwar kommt es noch zu kleineren Logikfehlern wie falschen Schatten und zum Teil surrealen Zusammensetzungen, die meisten Ergebnisse sind jedoch, gerade im Vergleich zu den generierten Videos, nahezu glaubwürdig.

Was Teil des ursprünglichen Bildes ist, lässt sich hier noch recht gut feststellen, da die ergänzten Objekte Unstimmigkeiten aufweisen. Für realistischere Ergänzungen, zum Beispiel des Hundes, wäre eine Nachbearbeitung von Licht, Schatten, Farbe und Glanzlichtern hilfreich, diese sind aber im Moment mit dem Tool nicht möglich. Dafür können pro Prompt mehrere Bilder ausgegeben werden, aus denen man das beste Bild auswählen kann.

Durch die Vielzahl an unterschiedlichen Funktionen bietet das Tool die verschiedensten Einsatzmöglichkeiten in der Produktion von audiovisuellen Inhalten, wobei insbesondere das Erstellen von künstlichen Fotografien und Videos im Vordergrund steht. Die Funktionen zur Bildmanipulation ermöglichen ein schnelles Veranschaulichen von Ideen, da durch Text- oder Bildeingabe authentische Ergebnisse generiert werden. Gerade in der Kommunikation von wissenschaftlichen Inhalten ergeben sich so neue Möglichkeiten, um Inhalte zu visualisieren. Beispielsweise könnten Klimaforschende mithilfe des Tools auf die Konsequenzen im Zusammenhang mit dem Klimawandel aufmerksam machen, indem sie fotorealistische Bilder generieren, auf denen bereits jetzt die ökologischen Auswirkungen eines Temperaturanstiegs zu sehen sind. Besonders Social Media Beiträge oder Präsentationen können so durch ansprechende Visualisierungen ergänzt werden.

Wrap-Up

Auch wenn einige Ergebnisse noch ausbaufähig sind, bietet das Tool eine schnelle und einfache Möglichkeit, Gestaltungsideen auf neue Art und Weise zu visualisieren. Es kann Produktionsprozesse verkürzen und ermöglicht Bearbeitungen und Bildmanipulationen, ohne dass technische Vorkenntnisse nötig sind. Besonders interessant für den Einsatz in der Wissenschaftskommunikation könnte dabei das Visualisieren abstrakter oder künftiger Szenarien sein, wie beispielsweise den Auswirkungen des Klimawandels auf unser Ökosystem. Allerdings gelingen nicht alle Vorhaben auf Anhieb, weshalb das Arbeiten mit Gen‑2 von Runway Research viel Ausprobieren erfordert und gerade das Personalisieren und Anpassen der Ergebnisse etwas Geduld und Kreativität im Schreiben der Prompts erfordert. Die einfache Bedienung lädt genau dazu ein und die generierten Ergebnisse machen Spaß, auch wenn ein gutes Ergebnis nicht bei jeder Spielerei garantiert ist.