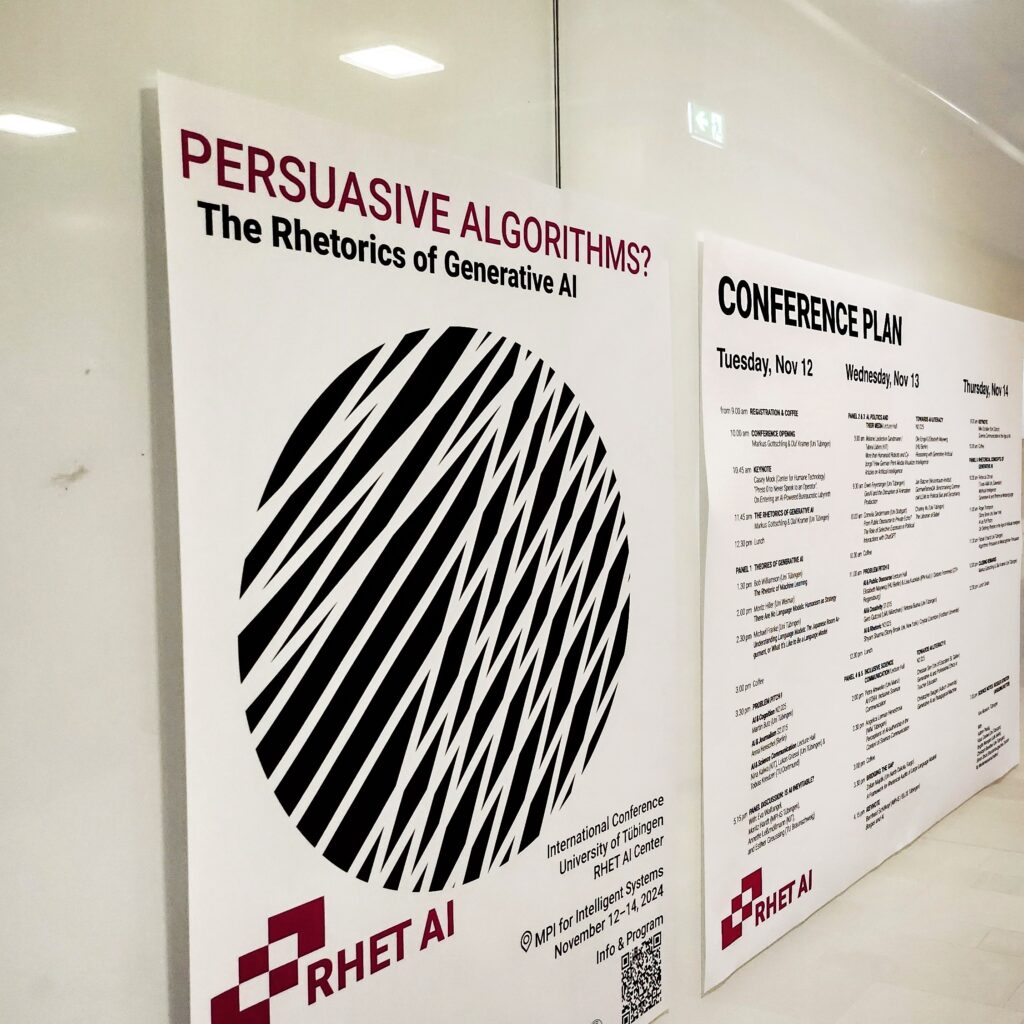

Im November des letzten Jahres fand unser großes Event, die Persuasive Algorithms Tagung, im Max-Planck-Institute for Intelligent Systems (MPI-IS) in Tübingen statt. Dafür reisten Teilnehmende von vielen verschiedenen deutschen Universitäten, wie zum Beispiel der TU Braunschweig, der HU Berlin, oder der LMU München, an. Es gab aber auch viele Teilnehmende von internationalen Universitäten, wie beispielsweise Wissenschaftler:innen der New Yorker Fordham University, der deutschschweizerischen University St. Gallen, oder der Universität Zürich. Insgesamt trafen Fachrichtungen wie Journalismus, Machine Learning, Pädagogik und natürlich Wissenschaftskommunikation, Rhetorik und Medienwissenschaft zusammen. Welche Fragen aufgeworfen, welche Perspektiven beleuchtet und welche Impulse für den Diskurs über Künstliche Intelligenz gegeben wurden, erfahrt ihr hier im Rückblick der Tagung.

Dienstag, 12. November 2024

Am Dienstag eröffneten Olaf Kramer und Markus Gottschling (beide Uni Tübingen) die dreitägige Konferenz und stellten dabei auch die RhetAI Coalition vor. Die RhetAI Coalition ist eine internationale Forschungsgemeinschaft, die vom RHET AI Center gemeinsam mit der Stony Brook University, dem Center for Humane Technology und seit 2024 auch der Auburn University getragen wird. Ziel der Kooperation ist es, den Austausch zwischen Wissenschaft, gemeinnützigen Partnern und der KI-Industrie zu fördern, um verantwortungsvolle Rahmenbedingungen für den Umgang mit den bislang unkontrollierten Überzeugungskräften von Künstlicher Intelligenz zu entwickeln.

Was hat es mit Character.AI auf sich?

Character.AI wird als sogenannter "companion chatbot" eingestuft. Hinter der Open Access App stehen die Gründer Noam Shazeer und Daniel De Freitas. Millionen von User:innen, gerade Teenager:innen, erschaffen sich mit der App Bots, die menschliche Elternteile, Partner:innen, oder Freund:innen ersetzen sollen. Der Bot ahmt das menschliche Verhalten nach (Stichwort: Anthropomorphisierung der KI) und geht in der Regel unterstützend auf die Klagen des menschlichen Gegenübers ein. Seine Kommentare können dadurch auch eine drastische dunkle, unangemessene; oder gar gewalttätige Wendung annehmen. Es ist daher äußerst wichtig, immer eine emotionale Distanz zu KI-Bots aufrecht zu erhalten.

Im Anschluss daran fand die erste Keynote "‘Press 0 to Never Speak to an Operator‘: On Entering an AI-Powered Bureaucratic Labyrinth" von Casey Mock (Center for Humane Technology) statt. Mock orientierte sich an der Frage, wer denn kontrolliere, mit welchen Daten KIs trainiert werden. Das zentrale Problem – künstliche Intimität – wurde am Beispiel des Falles von Character.AI gezeigt.

Künstliche Intimität beschreibt die von KI-gestützten Chatbots erzeugte Illusion einer engen, persönlichen Beziehung zwischen Mensch und Maschine. Dabei simulieren die Bots durch natürlich wirkende Kommunikation und empathischen Reaktionen menschliche Nähe, ohne jedoch echte Emotionen oder Bindungen zu empfinden. Manche Menschen lassen sich davon täuschen und entwickeln eine emotionale Bindung zu den Bots. Sie fühlen sich von ihnen bestätigt und verstanden und fragen diese um Rat, statt ihre Mitmenschen.

Der letzte Programmpunkt des Vormittags war ein gemeinsamer Vortrag von Olaf Kramer und Markus Gottschling über die Rhetorik von generativer KI, der diesen ersten Teil der Tagung abrundete.

Foto: @Silvester Keller

Weitere spannende Vorträge folgten nach einer einstündigen Mittagspause, beispielsweise von den Machine-Learning Wissenschaftlern Bob Williamson und Michael Franke (beide Uni Tübingen) zu den Themen "The Rhetoric of Machine Learning" und "Understanding Language Models: The Japanese Room Argument, or What It’s Like to Be a Language Model". Diese beeindruckten durch ihre inhaltliche Tiefe, ebenso wie die nach einer kleinen Kaffeepause folgenden Problem Pitches. Diese waren ein Highlight des Tages: Als neuartiges Konferenzformat, das aktives Mitdiskutieren förderte, fand dieses Format großen Anklang bei den Teilnehmenden.

Wie funktionieren Problem Pitches?

Das Format der "Problem Pitches" schafft Raum für die Teilnehmenden, über mit anderen Wissenschaftler:innen über Probleme und Fragen zu diskutieren, die ihnen während ihrer Forschung zu generativer KI begegnen. Diese Probleme durften in vielseitigen Formen von Konzepten (inter‑, oder transdisziplinär, theoretisch, praktisch, oder weitere) dargestellt werden. Sie sollten mit dem Ziel der Reflexion, Beratung und Vermittlung möglicher Lösungen formuliert werden. Diese Probleme werden dann in Kleingruppen diskutiert.

Gepitcht haben Anna Henschel (Redakteurin Wissenschaftskommunikation.de) mit "AI & Journalism" und Nina Kalwa (KIT) gemeinsam mit Lukas Griessl (Universität Tübingen) und Tobias Kreutzer (TU Dortmund) zum Thema "AI & Science Communication". Henschel nutzte ihre Redezeit, um die Teilnehmenden zu fragen, ob sie mit der derzeitigen Berichterstattung über KI in den Medien unzufrieden seien und darüber zu diskutieren, wie Journalist:innen in der Kommunikation über KI eine verständlichere Sprache nutzen können. Kalwa, Griessl und Kreutzer konzentrierten sich in ihrem Beitrag auf die Herausforderungen von KI für die Wissenschaftskommunikation.

Ziel der Pitches war es einerseits, den Forschenden eine Plattform zu bieten und andererseits, aktiven Austausch zu fördern, der den Pitchenden Impulse für ihre Arbeit lieferte und gleichermaßen die Teilnehmenden über den Stand Ihrer Forschungen zu informieren. Bemerkenswert war auch, dass einer der ursprünglich geplanten Pitches kurzfristig ausfiel, sich jedoch spontan eine Gruppe zum Thema zusammenfand, die trotz des fehlenden vorbereiteten Inputs intensiv diskutierte.

Abschließend zum ersten Konferenztag leitete die Techjournalistin Eva Wolfangel (MPI-IS) eine Podiumsdiskussion mit der Bezeichnung "Is AI inevitable?" an, in der sie zu Beginn KI als eine "power (struggle) technology" umschrieb. Die Teilnehmenden Moritz Hardt (Direktor MPI-IS Tübingen), Annette Leßmöllmann (KIT) und Esther Greussing (TU Braunschweig) sprachen unter Wolfangels Moderation über die transformativen Auswirkungen von generativer KI auf Kommunikation, Bildung und Fairness. Im Verlauf der Diskussion stellte Wolfangel die Frage, wer eigentlich Zugang zu KIs habe, und diese kontrollieren könne – besonders im Kontakt der Wissenschaftskommunikation und der öffentlichen Wahrnehmung. Was bedeutet Autorität in einer solchen Gesellschaft und wer wird sie ausüben? Diese Fragestellung führte zu weiteren, tiefgehenden Überlegungen: Greussingfragte, was Expertise heute überhaupt noch bedeute und wie sie sich verändere, wenn KI als "Experte" aufträte. Leßmöllmann wollte wissen, wie KIs, Large Language Models oder Social Media die Demokratie unterstützen könnten. Die Diskussion verdeutlichte schnell: Alle müssen sich aktiv in den KI-Diskurs einbringen und ihre Position in diesem Feld finden.

Nach diesem vielseitigen und informativen ersten Tag der Persuasive Algorithms Tagung ging es gemeinsam zum Abendessen in den Neckarmüller, ein bekanntes Tübinger Lokal mit schwäbischen Spezialitäten. So konnte jede:r gestärkt in den nächsten Tag starten.

Mittwoch, 13. November 2024

Eindrücke des zweiten Konferenztages. Fotos: @Silvester Keller

Am Mittwochmorgen drehte sich in zwei Panels alles um die übergeordneten Themen "AI, Politics and their Media" und "Towards AI Literacy". Im erstgenannten Panel sprachen Melanie Leidecker-Sandmann und Tabea Lüders (beide KIT) über das Thema "More than Humanoid Robots and Cyborgs? How German Print Media Visualize Articles on Artifical Intelligence". Beide Wissenschaftlerinnen beschäftigen sich mit dieser Frage auch in ihrem aktuellen Preprint, den sie gemeinsam mit drei weiteren Forschenden gestalten. Weitere Vorträge des Panels waren "GenAI and the Disruption of Animation Production" von Erwin Feyersinger, Animationsexperte in der Medienwissenschaft an der Universität Tübingen und "From Public Discourse to Private Echo? The Role of Selective Exposure in Political Interactions with ChatGPT" von Cornelia Sindermann (Universität Stuttgart).

Im zweiten Panel, das gleichzeitig stattfind, sprachen Ole Engel und Elisabeth Mayweg (HU Berlin) über "Reasoning with Generative Artificial Intelligence". Jan Batzner vom Weizenbaum-Institut hielt einen Vortrag über "GermanPartiesQA: Benchmarking Commercial Large Language Model for Political Bias and Sycophancy" und Charley Wu (Universität Tübingen) sprach über "The Librarian of Babel" im Zusammenhang mit AI Literacy.

Nach einer Pause ging es wieder weiter mit Problem Pitches zu den Themen "AI & Public Discourse", "AI and Creativity" und "AI & Rhetoric". Während des Pitches "AI & Public Discourse" wurde daher beispielsweise in Gruppen über verschiedene Aspekte des Einsatzes von KI in Diskursen und öffentlichen Diskussionen debattiert. (Foto: @Silvester Keller)

Am Nachmittag hatten die Teilnehmenden die Gelegenheit, durch weitere Vorträge in den Panels "Inclusive Science Communication" und "Towards AI Literacy" neue Impulse zu erhalten. Die Themen reichten von "AI Fora: Inclusive Science Communication" bis hin zu "Generative AI as Pedagogical Machine".

Außerdem widmete sich Zoltan Majdik (North Dakota State University) ausführlich dem Thema "Bridging the gap: A Framework for Rhetorical Audits of Large Language Models" und beleuchtete dabei, wie rhetorische Elemente auf KI-Systeme übertragen werden können. Dabei ging es insbesondere um rhetorische Tropen, deliberative Normen und semantische Komplexität. Majdik zeigte, dass generative KI häufig Metaphern wie etwa Kriegsbilder erzeugt, die den Diskurs über KI beeinflussen. Außerdem hob er die Bedeutung von Diskurswerten wie Validität hervor, die eine entscheidende Rolle für die Akzeptanz von KI-generierten Beiträgen spielen. Er betonte, dass es notwendig sei, semantisch reichhaltige Inhalte zu schaffen, um die Kommunikation überzeugender und wirkungsvoller zu gestalten. Dadurch können KI-Systeme besser in bestehende Diskurse eingebunden werden.

Bernhard Schölkopf (MPI-IS/ELLIS Tübingen) hielt die letzte Keynote des Tages. In seiner Forschung bezieht er sich auf Jorge Luis Borges und verbindet dessen philosophischen Anschauungen mit Künstlicher Intelligenz im heutigen Zeitalter. In seinem Vortrag drehte sich demnach alles um das Konzept des kulturellen Lernens, das für menschliches Verständnis und Kommunikation zentral ist, jedoch von KI-Forschenden bisher selten berücksichtigt wird. Schölkopfs Ansatz sieht vor, Modelle speziell auf kulturelles Lernen zu trainieren. Das sei besonders wichtig, da Menschen die Welt oft durch Fiktion und Narrative erfassen, weshalb kulturelles und fiktionales Wissen auch für die Mensch-Maschine-Kommunikation eine zentrale Rolle spiele. Derzeit befinde sich KI jedoch noch auf dem Niveau der Mustererkennung: Es sei noch nicht in der Lage, Kausalität zu verstehen.

Donnerstag, 14. November 2024

Foto: @Silvester Keller

Was ist ein KI-Ouroboros?

Ein weiteres Thema von Mike Schäfers Vortrag war das Konzept des KI-Ouroboros. Hier geht es darum, dass KI-Generatoren zunehmend mit KI-generierten Inhalten gefüttert werden. Dieser Kreislauf erinnert an den Ouroboros aus der antiken Mythologie, das symbolische Bild einer Schlange, die sich selbst in den Schwanz beißt. Übertragen auf den Kontext KI bedeutet das, dass der Inhalt, der von Künstlichen Intelligenzen erzeugt wird, wiederum KIs als Lernmaterial dient. Dadurch entsteht ein sich selbst verstärkender Zyklus, in dem KI-Systeme ihre eigenen Inhalte nutzen, um weiter zu lernen und neue Inhalte ohne menschliche Inputs zu generieren.

Die Vormittagsvorträge des letzten Tages der Veranstaltung beschäftigten sich mit der Verknüpfung von Literaturwissenschaft, Philosophie und Rhetorik mit KI. Eröffnet wurde der Tag durch Mike Schäfer (Universität Zürich) mit einer Keynote über Wissenschaftskommunikation in Zeiten von KI. Diese verdeutlichte, dass Künstliche Intelligenz einen tiefgreifenden Einfluss auf die Wissenschaftskommunikation hat und haben wird – sowohl als Chance als auch als Herausforderung. Während KI dazu beitragen kann, evidenzbasierte Diskussionen zu fördern und Informationen besser zugänglich zu machen, birgt sie auch Risiken durch die Verbreitung von Fehlinformationen. Die zunehmende Nutzung von KI-Tools wie JECT.AI zeigt, wie sich die Arbeitsweisen im Journalismus und in der Wissenschaftskommunikation wandeln. Diese Entwicklungen machen deutlich, dass ein kritischer und verantwortungsvoller Umgang mit KI unverzichtbar ist, um ihre Potenziale sinnvoll zu nutzen und ihre Grenzen zu erkennen.

Das letzte Panel der Persuasive Algorithms Tagung bestand aus diversen Unterthemen zu "Rhetorical Concepts of Generative AI". Unter anderem sprach Fabian Erhardt (Universität Tübingen) über "Algorithmic Persuasion as Metacognitive Persuasion". In seiner Forschung untersucht Erhardt, wie KI-gestützte Überzeugungsstrategien mit metakognitiven Prozessen zusammenhängen. Er stellte in seiner Analyse vor, ob und inwiefern algorithmische Kommunikationsformen gezielt metakognitive Mechanismen ansprechen – also die Art und Weise, wie Menschen ihr eigenes Denken und ihre Überzeugungen reflektieren.

Nach einem letzten gemeinsamen Mittagessen, vielen positiven Stimmen und der Verabschiedung in kühler Novemberluft, trennten sich die Wege der Teilnehmenden, mit dem ausdrücklichen Wunsch nach Wiederholung des mehrtägigen Events, bei dem Wissenschaftler:innen aus verschiedenen Disziplinen zusammentreffen und sich austauschen können. (Foto: @Silvester Keller)

Für alle Interessierten gab es am Abend zusätzlich die Science Notes Veranstaltung im Kino Museum, moderiert von Olaf Kramer. Diese war Teil der Science and Innovation Days der Universität Tübingen und wurde von dem Cognitive Science Center begleitet. Hier ging es um die Erforschung und Diskussion von Strategien, wie Online-Debatten fairer und konstruktiver gestaltet werden können, um zur Stärkung unserer demokratischen Kultur beizutragen. Kurzum: Wie können wir "besser streiten".

Wir bedanken uns bei dem Organisationsteam und allen Helferinnen und Helfern, die so ein großartiges Event überhaupt erst möglich gemacht haben.

Hier geht es zur Tagungsankündigung und Programmablauf 2024.